Es gibt verschiedene Möglichkeiten, Seiten vor der Indexierung von Google zu “beschützen”: Mit der robots.txt, mit dem Linkattribut rel=”nofollow” und mit dem Meta Robots Tag.

Doch stellen sich einige Fragen:

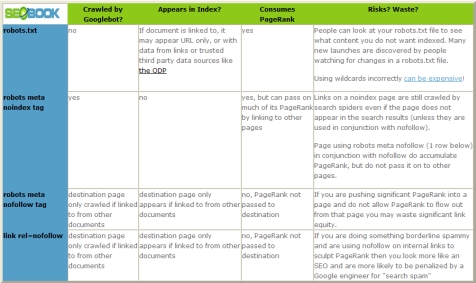

- Bei welcher der 3 Methoden werden die vermeintlich ausgeschlossenen Seiten von Suchmaschinen gecrawlt?

- Bei welcher der 3 Möglichkeiten ist es möglich, dass die Seiten trotzdem im Index der Suchmaschinen auftauchen?

- Bei welcher Methode wird Pagerank auf die ausgeschlossenen Seiten vererbt, bei welcher nicht?

- Welche Risiken bieten die 3 Methoden jeweils?

Die folgende Tabelle, fast ein kleines Cheat Sheet, gibt die Antworten auf diese 4 wichtigen Fragen:

Gefunden habe ich diese tolle Tabelle auf SEOBOOK.com, dem Blog von Aaron Wall. Er verfasste hier den Beitrag mit dem Titel “Robots.txt vs Rel=Nofollow vs Meta Robots Nofollow“.

Fazit: Lesen!

[…] Walter erklärt in seinem Blog wie man durch den richtigen Einsatz von robots.txt oder rel=”nofollow” die Suchmaschinen an der […]

hm, wenn die ausführungen zu link rel=nowfollow im feld “risks/waste” auch nur ansatzweise stimmen, wäre das schon sehr problematisch, wenn man das so einsetzt.

aber generell witzig finde ich die SEO trends. im frühling 08 war pagerank sculpting mit den ganzen maßnahmen der absolute SEO trend. jetzt, nach 2 pagerank updates, wird wieder zurückgerudert (meine nicht dich, sondern allgemein).

wie hat omi immer gesagt, nichts wird so heiß gegessen, wie es gekocht wird. 😀

Ich halte Pagerank Sculpting im richtigen Rahmen immer noch für sinnvoll 🙂

Internes Nofollow finde ich für Feed oder Druckversion (wenn vorhanden) sinnvoll, um Dublicate Content zu vermeiden; soviel SEO wird Google wohl erlauben.

Allerdings weiß ich nicht, wie man bei gängigen CMS einen einzelnen Link im Menü auf “nofollow” stellt (z.B. das Impressum). Deshalb habe ich das Thema bisher nicht weiter verfolgt.

Danke für das Cheatsheet, schön übersichtlich dargestellt, was man sonst in 5-seitigen wirren Threads zusammenklauben muss 😉

Na da fehlt doch was … das Outbound-Script. In vielen Fällen die einzig richtige Lösung 😉

Matthias: Gebe dir vollkommen Recht.